** ,一场突如其来的支付系统崩溃让自动发卡网陷入瘫痪,犹如心脏骤停,故障发生后,技术团队紧急启动应急预案,72小时内争分夺秒展开“手术式”修复:排查发现是第三方支付接口异常与数据库并发瓶颈叠加所致,团队连夜重构代码、扩容服务器,并临时启用备用通道以恢复订单流转,期间,客服全员上线应对用户投诉,官方每两小时通报进展以缓解信任危机,最终系统在第三天凌晨恢复,但暴露出对单一支付商的过度依赖问题,此次事件推动平台建立多链路冗余支付体系,也为行业敲响技术容灾的警钟。

当"收银台"突然罢工

凌晨2点17分,我的手机突然疯狂震动。

「老板,支付接口全挂了!客户付不了款!」技术负责人的消息像一盆冰水浇在我头上。

我猛地从床上弹起来,抓起电脑,后台数据显示:过去30分钟,有47笔订单支付失败,3个客户在客服窗口骂娘,还有十几个直接退款走人。

这是我们自动发卡网运行两年以来第一次大规模支付瘫痪——这个靠虚拟商品交易吃饭的"小店",突然被掐断了现金流。

解剖"心脏":自动发卡网的支付系统长什么样?

我们的业务很简单:卖游戏点卡、软件授权码这类虚拟商品,用户付款→系统自动发卡→完成交易,听起来像自动售货机,但实际流程复杂得多:

- 用户下单:选择商品,进入支付页面

- 支付网关选择:根据金额/成功率自动分配通道(支付宝、微信、第三方支付)

- 异步回调验证:支付平台通知我们"钱已到账"

- 库存核销:从数据库调取一个未使用的卡密

- 交付终端:在网页展示卡密,同时邮件/SMS发送

这套系统平时像瑞士钟表般精准,直到今晚——支付网关的回调通知突然延迟高达8分钟,导致系统误判超时,自动取消了已付款的订单。

手术台上的72小时

第一阶段:止血(0-12小时)

- 紧急切换备用支付通道

- 手动处理积压订单(用Excel核对支付记录和卡密发放)

- 客服全员加班安抚客户

这时发现最致命的问题:我们过度依赖单一支付服务商,当他们的服务器出现区域性故障时,我们连Plan B都准备不足。

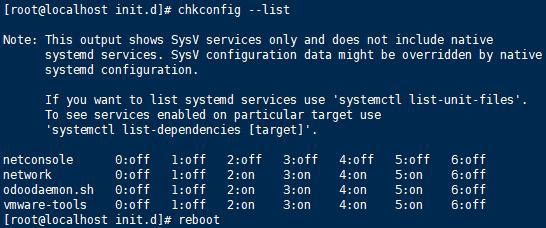

第二阶段:重建血管(12-48小时)

技术团队做了三件事:

- 多通道负载均衡:接入了4家新支付接口,根据实时成功率动态分配流量

- 增加异步校验:除了支付平台回调,每5分钟主动查询未确认订单

- 建立本地日志:所有交易流水在本地存证,不再完全依赖第三方数据

第三阶段:安装"起搏器"(48-72小时)

最关键的升级:开发了分布式事务系统,现在即使某个支付接口完全崩溃:

- 用户付款后会被标记为"待确认"

- 库存卡密进入临时冻结状态

- 72小时内只要收到任意通道的到账通知,立即自动补发

后遗症与新生

这次事故让我们损失了当天23%的营收,但换来三个宝贵认知:

- 支付系统不能有单点故障(现在连短信通知都准备了三个服务商)

- 客户容忍度比想象的低(超过90秒没收到卡密就会投诉)

- 虚拟商品的特殊性:一旦卡密泄露就无法撤回,所以支付验证必须比实体商品更严格

我们的系统会定期进行"停电演练"——随机关闭某个支付通道,测试故障转移能力,就像给心脏做压力测试,只为确保下次危机来临时,这个自动发卡的小店还能继续平稳跳动。

(深夜的办公室里,我盯着监控屏上新设计的支付拓扑图,突然觉得它像极了人体循环系统——每一根血管都必须有备用的通路,毕竟在这个24小时运转的虚拟商业世界里,停跳一分钟,流失的都是真金白银。)

本文链接:https://www.ncwmj.com/news/1187.html